Blog

Konfigurasi Robots.TXT Mengatur Mesin Pencari Melakukan Crawl Perayapan

Saya bisa tebak. Sebagian dari anda mungkin belum mengetahui apa yang dimaksud file robots txt, apa fungsinya dan bagaimana cara memasangnya, benar? Sebagian lagi mungkin sedang mencari format / formula yang tepat pengisian robots.txt untuk situs anda. Sebenarnya, baik pengertian, cara pemasangan dan penggunaan file ini cukup sederhana. File robots.txt adalah file teks sederhana yang ditempatkan di server web Anda yang memberi tahu webcrawlers seperti Googlebot jika mereka harus mengakses file atau tidak. Ya, pengertiannya hanya itu saja, mudah dicerna dan dipahami.

Alasan Anda Wajib Mempelajari Robots.txt

Pada pengelolaan website, hal yang pasti anda temukan adalah masalah pada proses perayapan bot mesin pencari. Terkadang mereka tidak bisa mengakses file yang penting pada hasil pencarian dikarenakan kesalahan konfigurasi robots.txt yang sengaja maupun tidak disengaja, banyak kemungkinan bisa saja terjadi. Bisa juga anda tidak menginginkan suatu file yang bersifat rahasia tidak ingin berada di hasil pencarian. Beberapa alasannya sebagai berikut :

- Penggunaan file robots.txt yang tidak sesuai bisa merugikan rangking Anda.

- File robots.txt mengontrol bagaimana spider mesin pencari melihat dan berinteraksi dengan halaman Web Anda.

- Anda ingin mempelajari cara SEO pengelolaan web yang benar?, maka pelajari google guideliness. Pada pedoman tersebut terdapat pembahasan mengenai file robots txt

- Hubungan bot mesin pencari dan file robots txt bersifat fundamental bagaimana mesin pencari bekerja terhadap website anda.

Terkadang seorang hacker iseng mengerjai website anda, memakai robots.txt untuk melakukan sabotase pemblokiran terhadap file penting. Kabar baiknya anda bisa mengetahuinya pada akun search console google webmaster pada tab crawl >>> robots txt tester.

Bagaimana Format Dari Robots.Txt ?

Sebelum anda mencoba menyusun formulasi dari robots.txt, sebaiknya anda mengetahui apa saja hal penting dalam penulisan dan pengaturannya. Robots.txt hanya mengenal dua hal dasar saja bot mesin pencari, disalow (block) perayapan terhadap file tertentu atau folder tertentu secara keseluruhan.

Format Dasar Robots.Txt

Terdapat 4 format dasar pada konfigurasi penulisan filet robots yang bisa anda terapkan pada situs web anda, diantaranya :

- Allow Full Access => Mempersilahkan spider / bot mesin pencari merayapi keseluruhan isi web anda.

User-agent: *

Disallow:

- Block All Access => Melarang spider / bot mesin pencari merayapi keseluruhan isi web anda.

User-agent: *

Disallow: /

- Block One Folder => Melarang spider / bot mesin pencari merayapi satu folder beserta keseluruhan file dibelakangnya.

User-agent: *

Disallow: /folder/

- Block One File => Melarang spider / bot mesin pencari merayapi keseluruhan isi web anda.

User-agent: *

Disallow: /file.html

Hal Penting Mengenai Format File Robots txt

Agar anda mengerti sebaik-baiknya, sehingga nantinya bisa membuat formulasi sendiri sesuai dengan kebutuhan web milik anda. Tentu saja membuat formulasi sendiri jauh lebih baik daripada menjiplak formulasi orang lain, toh web orang lain tidak sama dengan web milik anda.

Kemudian, terdapat beberapa format yang tidak standar (hanya dimengerti oleh sebagian bot spider saja) misalnya sebagai berikut, format penulisan robots.txt yang hanya dimengerti bot google dan beberapa lainnya :

- Allow – Menyarankan mesin pencari yang bisa mengindeks file atau direktori.

- Sitemap – Mendefinisikan lokasi sitemap situs anda.

- Crawl-delay – Mendefinisikan jumlah detik antara permintaan ke server Anda.

- Host – Menyarankan mesin pencari domain pilihan Anda jika Anda menggunakan “mirror”.

Dari ke empat format yang tidak standar diatas, hanya dua saja yang sering digunakan, allow dan sitemap.

Pemahaman User-agent Sebagai Bot (Spider)

User-agent adalah nama bot mesin pencari yang akan anda block atau persilahkan merayapi website. Jika anda menulis (*), artinya bahwa semua bot mesin pencari baik itu dari google, bing serta bot-bot lainnya secara umum termasuk didalamnya. Anda bisa saja hanya menginginkan satu atau beberapa bot saja yang anda larang merayapi file tertentu. Contoh anda tidak ingin bot tertentu merayapi isi web anda :

User-agent: googlebot

User-agent: yahoobot

User-agent: blekokbot

Disallow: /

Nama tiga bot diatas adalah contoh saja, bukan nama bot yang sebenarnya. Dengan format demikian maka ke tiga bot spider google, yahoo dan blekok tidak bisa mengakses keseluruhan isi web anda, tapi selain bot ketiganya yang disebutkan masih bisa.

Penggunaan Pengecualian “Allow”

Setiap ada kata ya pasti ada tidak, juga sebaliknya. Allow sebaiknya digunakan untuk pengecualian saja (tidak semua bot crawler mengerti “allow”), walaupun bisa juga digunakan sebagai perintah utama, misal “Allow:/”, sama dengan “Disallow:”. Contoh penulisan format “allow” sebagai pengecualian adalah sebagai berikut :

User-agent: Googlebot

Disallow: /folderA/

Allow: /folderA/blekok.html

Pada format penulisan diatas anda melarang google bot merayapi folder A, akan tetapi menginginkan tetap merayapi file tertentu (blekok.html).

Memasukan Sitemap Pada File Robots txt

Anda diperbolehkan memasukan sitemap situs web anda pada formulasi robots.txt, dengan demikian setiap bot crawler mesin pencari akan mengetahui peta situs (daftar isi) website anda.

Sitemap: https://thidiweb.com/sitemap_index.xml

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

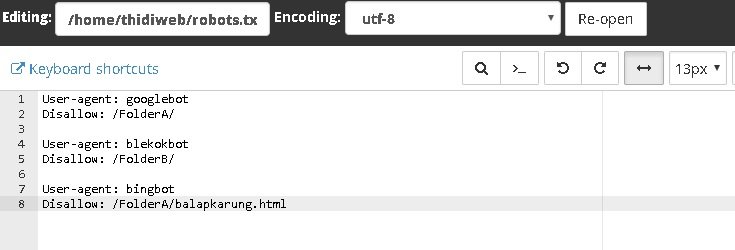

Perbedaan Perintah Pada Dua Bot atau Lebih

File robot txt juga bisa diatur agar setiap spider mesin pencari atau bot spider yang merayapi situs web anda memiliki perintah yang berbeda.

User-agent: googlebot

Disallow: /FolderA/User-agent: blekokbot

Disallow: /FolderB/User-agent: bingbot

Disallow: /FolderA/balapkarung.html

Pemasangan Robots.txt Pada Website dan WordPress

Jika website anda menggunakan flatform wordpress, maka anda tidak usah repot-repot melakukan konfigurasi awal, karena wordpress sendiri memiliki setting default bawaan perihal file robots txt.

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

Bahkan jika anda mencentang “Discourage search engines from indexing this site” pada Search Engine Visibility (halangi mesin pencari untuk mengakses website anda), ketika mengatur konfigurasi awal wordpress atau pada tab pengaturan (setting) >>> reading (membaca), sebenarnya anda melakukan konfigurasi disallow semua bot crawler mesin pencari.

User-agent: *

Disallow: /

Pada keadaan anda dimana anda mengaktifkan pencegahan mesin pencari melakukan perayapan pada wordpress, maka hal ini bersifat mutlak. Bersifat mutlak artinya anda tidak bisa menggantinya dengan menggunakan plugin robots.txt maupun cara manual pemasangan di cpanel.

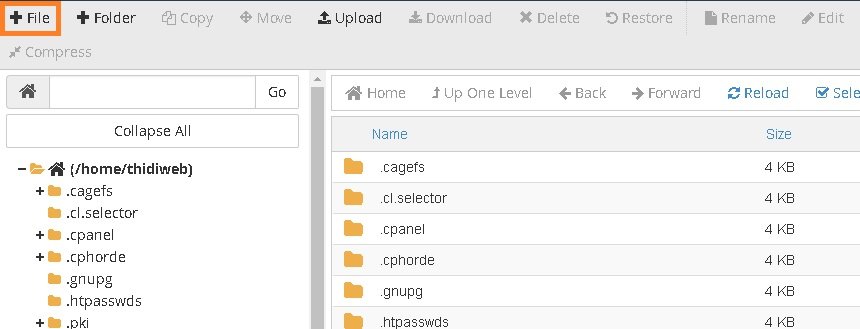

Pemasangan Manual Robots.txt Melalui Cpanel

Cara memasang file robots.txt pada cpanel bisa dikatakan sangat mudah, langkah pertama yang harus anda lakukan tentu saja mengakses cpanel server dimana wbsite anda disimpan.

- Klik file manager tempat semua data website anda disimpan.

- Klik folder data web anda disimpan. Jika web anda adalah domain utama maka umumnya akan tersimpan pada folder “public.html”, jika addon domain maka silahkan akses folder yang anda tentukan untuk menyimpan website addon domain web anda. Kemudian klik tambahkan file.

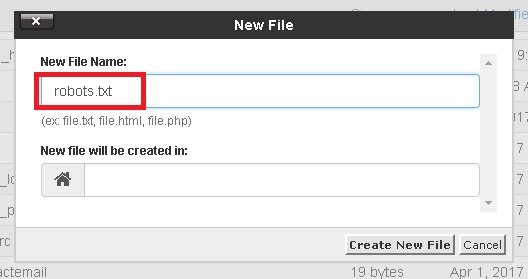

- Tuliskan nama file baru denga tulisan robots.txt. File “robots.txt” kosong ini akan tersimpan pada folder web anda.

- Isi file kosong “robots.txt” dengan formulasi (format) yang anda buat dengan cara klik “edit”.

- Klik save.

Pemasangan Robots.txt Menggunakan Plugin

Pada wordpress, memasang robots txt bukan sesuatu yang sulit (sebenarnya cara manualpun tidak sulit, hanya sedikit repot saja). Plugin yang cukup baik mengurusi masalah robots txt adalah virtual tobots txt. Cara pengaturannya juga sangat mudah, tidak berbeda dengan plugin lainnya. Setelah plugin terpasang pada wordpress selanjutnya anda hanya perlu mengakses pengaturan plugin di setting >>> virtual robots.txt.

Hanya tiga langkah saja yang bisa anda lakukan pada pengaturan.

- Centang jika anda ingin menghapus file robots txt apabila anda menonaktifkan plugin.

- Menyimpan perubahan yang sudah anda lakukan.

- Memeriksa apakah file robots txt web anda sudah berubah.

Submit Perubahan Robots TXT Pada Google Webmaster

Setelah anda melakukan perubahan file robots txt baik secara manual maupun menggunakan plugin, maka langkah selanjutnya adalah melakukan submit / re-submit pada akun search console google webmaster. Langkah-langkahnya dijelaskan sebagai berikut:

- Login ke akun google webmaster jika belum login.

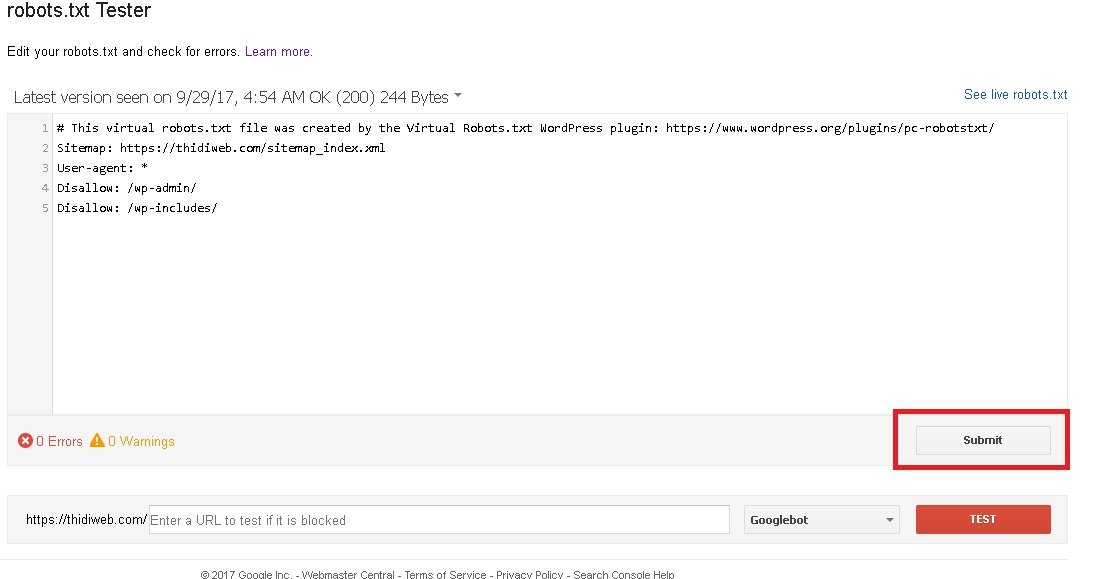

- Akses tab pengaturan Crawl >>> Robot.txt tester >>> klik submit. Sebelumnya untuk memastikan file robots txt yang baru anda buat, bisa meng-klik “see live robots txt” pada pojok kanan seperti yang terlihat pada gambar.

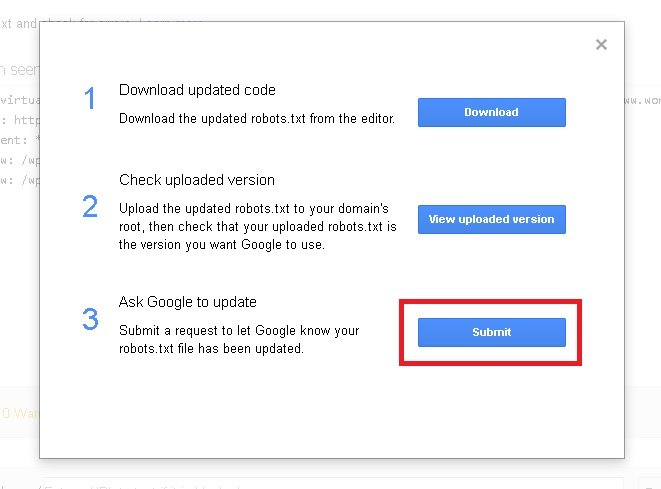

- Setelah klik tombol submit, selanjutnya muncul popup berisikan pilihan tindakan, silahkan anda klik submit pada urutan ke 3.

- Kemudian, setelah selesai file anda masih belum berubah, maka silahkan lakukan refresh pada browser anda.

Pengaturan file robots txt bukan suatu keharusan, terlebih jika website anda menggunakan cms wordpress. Namun suatu saat file ini bisa sangat berguna pada berbagai kondisi yang mengharuskan anda membuatnya. Dengan memahami konfigurasi robots txt setidaknya menambah wawasan anda mengenai pengelolaan website, terutama mengatur interaksi mesin pencari dalam melakukan pengindexan terhadap setiap elemen pada website yang anda miliki.

info@thidiweb.com.

makasi informasinya

Sama-sama gan…smoga bermanfaat….^^

makasih informasinya

Sama-sama gan…^^

makasih banyak ya gan atas info nya..

Ok sama-sama gan…semoga bermanfaat…^^

mantap sangat komplit dan mudah di pahami

Terimakasih atas ilmunya

Ok…sama2 gan senang bisa membantu…

Apakah berdampak jika sering mengganti robot.txt ini?. But thanks infonya

Seringnya mengganti robot.txt tidak berdampak apa-apa….namun jika tidak tepat akan berdampak negatif…

kalau seandainya robots.txt nya diakses orang tentu direktori yang kita rahasiakan itu akan terlihat,, bagaimana cara mengantisipasi hal ini

Fungsi dari robot txt adalah agar bot mesin pencari dilarang masuk untuk melakukan crawl yang kemudian tidak ditampilkan di hasil pencarian…jadi sama sekali bukan untuk manusia fungsinya…

Maaf mau tanya mas..

Apa perbedaannya jika di robot txt menggunakan format sitemap.xml dan sitemap.html

sitemap xml diperuntukan untuk robot mesin pencari, sedangkan sitemap html untuk manusia, seperti layaknya daftar isi….

Robot txt itu untuk mesin pencari, jika ingin memasukan sitemap ya xml…karena jika ada memasukan html tidak akan terbaca apa2…

terimakasih sudah berkunjung…salam ^^

gan, minta arahan nya dong cara setting robots buat website page

Di artikel diatas sudah dijelaskan gan…silahkan diperdalam…^^…salam

Mantap lengkap penjelasannya, saya baru bangun web yang rencananya mau dibikin portal. Semoga cepat keindex

Baik … Terima kasih sudah berkunjung dan semoga sukses dengan rencana web barunya… Salam